Les algorithmes jouent un rôle croissant dans la sphère publique, qu’il s’agisse de calculer le montant d’une aide sociale, d’attribuer une place en crèche ou d’évaluer les risques de défaillance des entreprises. La France s’est doté d’un cadre juridique en faveur d’une plus grande transparence de ces systèmes et d’un droit à l’explication pour les individus. Etalab, au sein de la direction interministérielle du numérique, porte plusieurs actions en ce sens. C’est dans ce cadre qu’Elisabeth Lehagre, chercheuse indépendante a été mandatée pour réaliser une étude internationale sur les outils d’évaluation d’impact algorithmique.

Une étude internationale des outils d’évaluation d’impact algorithmique

Nul ne doute aujourd’hui du fait que les algorithmes ont des impacts, positifs mais aussi parfois négatifs, sur les individus et la société. C’est pourquoi des gouvernements et des acteurs de la société civile ont développé des outils d’évaluation d’impact algorithmique (EIA). L’étude publiée ce jour présente un regard critique sur 7 outils développés dans le Monde (Royaume-Uni, Canada, Nouvelle Zélande, Etats-Unis et Union européenne).

A quoi correspondent ces évaluations, que contiennent-elles, comment sont-elles mises en oeuvre ? Voici quelques unes des questions traitées par Elisabeth Lehagre, en menant un travail de recherche documentaire complété par des entretiens avec les acteurs qui conçoivent, déploient ou observent ces outils. In fine, c’est la question de l’utilité de ces outils qui est posée.

Evaluer: quoi ? comment ? pourquoi ?

Le premier constat est celui de la diversité des outils examinés: il n’existe pas de modèle-type. Les évaluations d’impact algorithmique se présentent sous des formes et des contenus variés. Quelques exemples:

- L’AI Now Institute propose un cadre de bonnes pratiques incluant 5 recommandations d’ordre général (dont la mise en place de procédures pour la vérification et le suivi externe des impacts),

- Le Groupe d’experts de haut-niveau pour une IA de confiance, rassemblé par la Commission européenne, propose une liste de questions qui servent de base à l’auto-évaluation des systèmes,

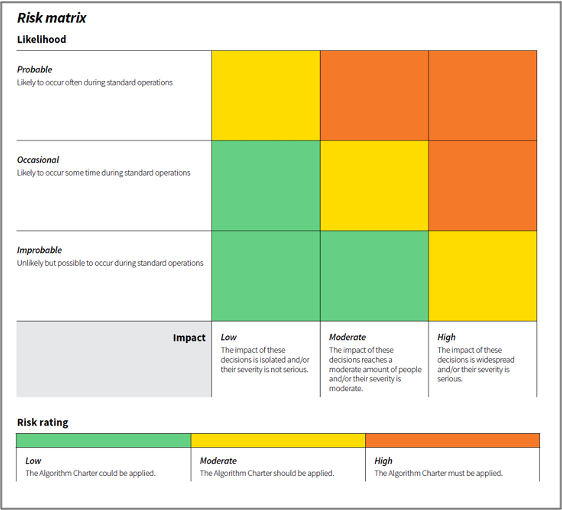

- Le Gouvernement de la Nouvelle Zélande intègre dans sa charte des algorithmes une matrice de risques, qui permet de quantifier la probabilité d’effets négatifs sur les personnes (effet improbable, occasionnel, probable) par rapport au nombre de personnes potentiellement impactées (faible, modéré, élevé).

L’outil proposé par le Gouvernement du Canada (conseil du Trésor) se distingue car il permet de calculer automatiquement le niveau de risques d’un systèmes en répondant à quelques questions. Selon le niveau d’incidence ainsi calculé, des recommandations particulières sont formulées.

La plupart des outils étudiés cherchent à évaluer les impacts individuels et sociaux, voire sociétaux, des systèmes algorithmiques mis en place. Mais, là encore, c’est la diversité qui prévaut. Certains outils mettent l’accent sur les droits fondamentaux (droits et libertés des personnes, droit à la vie privée, non-discrimination). D’autres privilégient une approche par domaine d’impact: bien-être, santé, environnement par exemple.

Des outils d’auto-évaluation qui doivent encore faire leurs preuves

Elisabeth Lehagre s’est aussi attachée à comprendre comment ces outils sont mis en oeuvre, en pratique. Deux questions émergent: la compréhension de ces outils par les acteurs qui sont censé les utiliser, et les limites de l’auto-évaluation. « L’évaluation d’impact est-elle suffisamment compréhensible pour être utilisable ? » s’interroge ainsi l’auteure de l’étude. Les difficultés de compréhension peuvent être multiples: difficulté à cerner de manière précise le périmètre et l’objet de l’évaluation (« systèmes d’intelligence artificielle », « algorithmes », « systèmes de décision automatisée » ?) mais aussi les domaines d’impact (« bien-être », « droits et libertés des personnes » ?). Les gouvernements canadiens et néo-zelandais ont ainsi dû mener des actions complémentaires: tenue d’ateliers pluridisciplinaires, proposition de définition précise des systèmes concernés, etc.

La seconde interrogation concerne l’auto-arbitrage. En effet, la très grande majorité de ces outils ont été pensés comme des outils d’auto-évaluation interne, où les personnes réalisant l’exercice d’évaluation sont aussi celles en charge de la conception et du déploiement de ces outils. Afin d’éviter les risques liés à l’auto-arbitrage (où les mêmes acteurs sont potentiellement juge et partie), plusieurs recommandations ont été développées, dont l’importance de rendre publique et transparente les évaluations d’impact algorithmique. La possibilité de faire participer des tiers (pairs en interne ou experts externes) à l’évaluation ou au contrôle des systèmes est une autre piste étudiée.

Une étude pour ouvrir le débat et faire connaître les outils

Par la publication de cette étude inédite en France, Etalab souhaite contribuer au débat, au niveau national et international, sur l’évaluation des impacts des algorithmes. Cette question est au coeur de la future régulation sur l’Intelligence artificielle dont une première version vient d’être rendue publique par la Commission européenne. Il s’agit aussi de donner accès à une large communauté de concepteurs de ces systèmes (au sein des administrations et au-delà) aux derniers outils existants au niveau international.

Télécharger l’étude complète (28 pages)