En application du rapport Villani, et au titre de l’action « Lab IA », visant à accompagner les administrations dans l’expérimentation et l’usage de l’intelligence artificielle, Etalab lance le projet « PIAF : Pour des IA francophones« .

Les enjeux : évaluer l’apport d’un jeu de données de questions-réponses construit nativement en français (plutôt qu’à partir de traduction automatique de datasets anglophones) sur l’entraînement des IA. PIAF vise ainsi à la fois à répondre à une question scientifique dans le champ du traitement automatique du langage naturel, et à construire, dans une démarche contributive, un jeu de données réutilisable. En associant largement contributeurs et partenaires au sein de l’administration et de la société civile, il permet aussi de mieux faire comprendre les défis de l’intelligence artificielle.

Disposer de données critiques pour des applications en IA, un enjeu de souveraineté

La stratégie nationale pour l’intelligence artificielle définie en mars 2018 à la suite du rapport Villani « Donner un sens à l’intelligence artificielle » a donné lieu à la mise en place à la Direction interministérielle du numérique d’un Lab IA. Annoncé lors du CITP d’octobre 2018 et porté par Etalab, ce programme vise à accompagner les administrations dans des projets d’IA, à animer une communauté et améliorer l’expertise publique et le partage d’expérience sur l’IA, ainsi qu’à mettre à disposition des outils et infrastructures mutualisés.

Le projet PIAF s’inscrit pleinement dans cette stratégie : mettre à disposition « des données critiques pour les applications en IA » (extrait du rapport Villani). L’ouverture et la mutualisation de données pour améliorer l’entraînement des IA peuvent concerner des différents types de données (images, texte…).

Dans le champ du texte, et plus précisément du traitement automatique du langage, la mise à disposition de données d’entraînement de questions-réponses en français apparaît comme un premier cas d’application : il n’existe pas, à ce jour, de jeux de données de questions-réponses ouverts pour entraîner des applications d’IA francophones. L’objectif à terme est ainsi d’améliorer la performance d’agents conversationnels ou de moteurs de recherche. Proposer une telle ressource constitue un enjeu de souveraineté et de performance publique, autant pour les administrations que pour la communauté scientifique et les entreprises.

Une première étape scientifique : tester la performance d’IA entraînées avec des données de questions-réponses francophones

PIAF repose en partie sur une question scientifique. Il s’agit d’identifier si le fait de disposer de données d’entraînement natives en français apporte une réelle plus-value par rapport à l’usage de données traduites automatiquement.

Pour répondre à cette question, un protocole scientifique a été élaboré, inspiré du projet anglophone « SQuAD » mené à l’université de Stanford. Des modèles d’IA existants seront entraînés sur des bases en français natives (PIAF) et traduites en anglais afin de comparer leur performance.

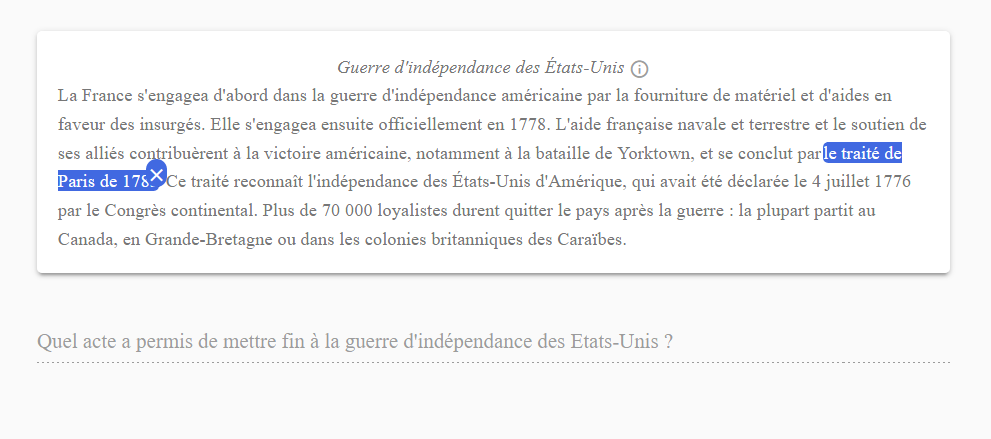

Comme dans beaucoup de projets d’IA, une phase d’annotation manuelle est nécessaire pour permettre l’apprentissage supervisé. Pour constituer le jeu de données natives en français, des extraits d’articles Wikipédia francophone seront « annotés » sur une plateforme développée en interne. L’annotation consiste ici à formuler une question dont la réponse se trouve dans le paragraphe affiché, et à localiser en regard la réponse dans le texte.

La première phase d’annotation vise à constituer une base de 20 000 questions-réponses qui validera ou invalidera l’hypothèse scientifique « les IA de questions-réponses sont-elles plus performantes lorsqu’elles sont entraînées sur des données natives en français ?« . En fonction de ces résultats, une phase d’annotation plus large sera ouverte pour atteindre 100 000 questions-réponses et structurer une base de données francophones ouverte.

Une démarche contributive et apprenante

Au-delà du projet scientifique et des enjeux de souveraineté pré-cités, le projet PIAF a pour ambition d’explorer, par l’action, les différents enjeux et défis du développement de l’IA dans la sphère publique.

S’inspirant des initiatives de sciences participatives et de projets contributifs comme Common Voice, PIAF fait le pari de la contribution volontaire.

La première étape d’annotation, visant à produire les 20 000 questions-réponses d’évaluation, se construit en particulier avec les agents publics. Comment ? :

- Des permanences hebdomadaires (ou « annotathons », pour « sprints d’annotation ») ouvertes à tous

- Des ateliers de présentation ou de formation : l’équipe PIAF se rend dans vos organisations

Ces sessions proposent un format pédagogique et contributif. En découvrant le projet PIAF, les participants se familiarisent avec les enjeux de l’IA tout ayant l’opportunité de construire l’IA en enrichissant la base de données PIAF.

Un premier annotathon test a été organisé le 18 octobre 2019 (image ci-dessous).

A travers ces formats d’annotation, et via des interactions avec des partenaires – administrations, acteurs de la recherche, entreprises – le projet PIAF souhaite aussi explorer d’autres enjeux, notamment : les cas d’usages de PIAF, les modalités de réutilisations d’un jeu de données d’entraînement ouvert, les communautés de contributeurs à des projets publics, la francophonie dans l’IA.

Pour explorer ces questions, un premier OpenLab a été organisé début octobre, et des rencontres seront organisées tout au long du projet.

=> Comment participer à PIAF et découvrir les prochaines étapes du projet ?

Rendez-vous sur piaf.etalab.studio pour découvrir plus en détails le projet.

S’inscrire à la liste de diffusion pour participer aux annotathons. En participant aux annotathons, vous pourrez découvrir l’interface d’annotation (version beta) et faire partie des 1ers contributeurs certifiés !